深度强化学习算法与应用研究现状综述

导读:本文详述了基于值函数和策略梯度的 DRL 算法,对深度Q网络、深度策略梯度及相关算法进行了梳理,并概述了近年来DRL在视频游戏、导航、多智能体协作以及推荐系统等领域的应用。

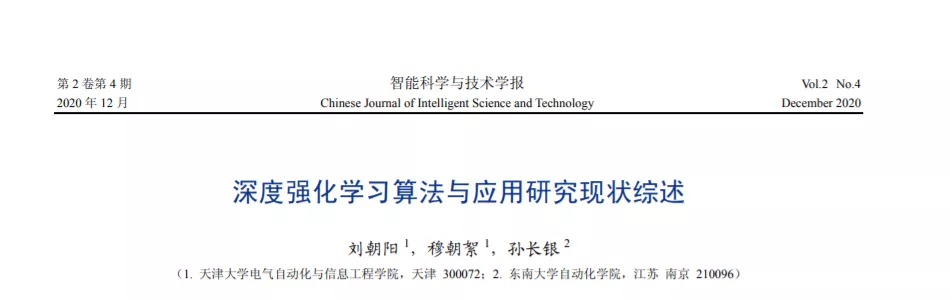

深度强化学习主要被用来处理感知-决策问题,已经成为人工智能领域重要的研究分支。概述了基于值函数和策略梯度的两类深度强化学习算法,详细阐述了深度Q网络、深度策略梯度及相关改进算法的原理,并综述了深度强化学习在视频游戏、导航、多智能体协作以及推荐系统等领域的应用研究进展。最后,对深度强化学习的算法和应用进行展望,针对一些未来的研究方向和研究热点给出了建议。

近年来,强化学习[1]方法受到了广泛的关注,其主要被用于解决序列决策问题。强化学习受到动物学习中试错法的启发,将智能体与环境交互得到的奖励值作为反馈信号对智能体进行训练。强化学习一般可以用马尔可夫决策过程(Markov decision process,MDP)表示,主要元素包含(S, A, R, T,γ),其中,S表示所处的环境状态,A表示智能体采取的动作,R表示得到的奖励值,T表示状态转移概率,γ表示折扣因子。智能体的策略π表示状态空间到动作空间的一个映射。当智能体状态st∈S时,根据策略π采取动作at∈A,进而根据状态转移概率T转移到下一个状态st+1,同时接收环境反馈的奖励值rt∈R。强化学习的目标是不断地优化智能体的策略,从而得到最大的奖励值。智能体的值函数和动作值函数分别为V(st)和Q(st,at) ,用来评估智能体在状态st下所能得到的长期奖励的期望。智能体的最优策略可以通过优化值函数得到。

深度学习拥有强大的感知能力,在一些应用场景下甚至已经超越了人类的感知水平[2]。它采用深度神经网络提取原始输入的特征,在图像识别、语音识别、机器翻译等多个领域取得了成功。深度强化学习(deep reinforcement learning,DRL)基于深度学习强大的感知能力来处理复杂的、高维的环境特征,并结合强化学习的思想与环境进行交互,完成决策过程[3,4]。2015 年 DeepMind 团队在 Nature上发表了深度Q网络(deep Q-network,DQN)的文章[5],认为DRL可以实现类人水平的控制。2017年, DeepMind 团队根据深度学习和策略搜索的方法推出了 AlphaGo[6],击败了围棋世界冠军李世石。此后,基于DRL的AlphaGo Zero在不需要人类经验的帮助下,经过短时间的训练就击败了AlphaGo[7]。2018 年,OpenAI 团队基于多智能体 DRL (multi-agent DRL,MADRL)推出了OpenAI Five,在Dota2游戏5v5模式下击败了人类玩家[8],并且在经过一段时间的训练后,击败了Dota2世界冠军OG 战队。2019 年,DeepMind 团队基于 MADRL推出的AlphaStar在StarCraftII游戏中达到了人类大师级的水平,并且在StarCraftII的官方排名中超越了99.8%的人类玩家[9]。可以看到,DRL在封闭、静态和确定性的环境(如围棋、游戏等)下,可以达到甚至超越人类的决策水平。

DRL算法主要分为两类:值函数算法和策略梯度算法[10,11]。值函数算法通过迭代更新值函数来间接得到智能体的策略,当值函数迭代达到最优时,智能体的最优策略通过最优值函数得到。策略梯度算法直接采用函数近似的方法建立策略网络,通过策略网络选取动作得到奖励值,并沿梯度方向对策略网络参数进行优化,得到优化的策略最大化奖励值。在算法应用的场景上,值函数算法需要对动作进行采样,因此只能处理离散动作的情况,而策略梯度算法直接利用策略网络对动作进行搜索,可以被用来处理连续动作的情况。近年来,将值函数算法和策略梯度算法结合得到的执行器ԟ评价器(actor-critic,AC)结构也受到了广泛的关注。在 AC 结构中,执行器使用策略梯度法选取动作,通过值函数对执行器采取的动作进行评价,并且在训练时,执行器和评价器的参数交替更新。

本文详述了基于值函数和策略梯度的 DRL 算法,对深度Q网络、深度策略梯度及相关算法进行了梳理,并概述了近年来DRL在视频游戏、导航、多智能体协作以及推荐系统等领域的应用。最后,总结了 DRL 目前面临的挑战,建议在采样和探索效率、奖励值设置、泛化能力等方面开展研究,更好地提升DRL算法的性能和应用效果。

http://www.infocomm-journal.com/znkx/CN/10.11959/j.issn.2096-6652.202034