腾讯发布业内首个AI安全攻击矩阵,可像查字典一样排查风险

导读:腾讯朱雀实验室则专注于实战攻击技术研究和 AI 安全技术研究,以攻促防、守护腾讯业务及用户安全。

近年来,AI 技术在图像识别、语音识别、自然语言翻译等领域得到广泛应用。因此,在关键的 AI 应用场景上,其安全问题也逐步成为企业所担忧和关注的话题。

如果说模型误判是对 AI 系统攻击,那么信息泄露就是对 AI 系统的窃取。这种攻击可导致模型功能被第三方还原,造成用户隐私的泄漏、公司信息资产被窃取等巨大危害。

一个良好的模型,往往需要大量的算力训练与高质量的数据支持。很多场景下,企业将训练好的模型部署在云端,开放 API 接口供用户使用。用户可以根据大量的输入查询,得到大量模型输出,从而对此系统建模,逆向还原其功能,进而降低商用模型的竞争力并削减其收益。

在医疗或金融领域,用户的数据是极为重要的资源,如果泄露,会造成严重的隐私危机和商业价值流失。由于机器学习是数据驱动的,研究者通常采用分布式方法打破数据孤岛,联合企业间数据,并保证数据安全。

但是在这种场景下,训练者依然有可能窃取数据端的内容。此外,如果项目成果以模型的方式交付,攻击者也有可能基于所得模型逆向恢复出训练数据,引发隐私危机。在考虑模型性能的同时,技术人员与用户也要对 AI 系统自身的安全有所考虑,确保 AI 模型在业务场景下的安全性,从而避免被攻击者轻易控制、影响、或欺骗,也避免造成结果误判或隐私数据泄漏等严重后果。9 月 25 日,腾讯发布业内首个 AI 安全攻击矩阵。这是一份具有高实用性的 AI 安全技术指导框架,首次全面梳理了学术及工业界最前沿的 AI 安全研究,并从攻击者视角系统列举了 AI 技术研发部署各个环节中的攻击过程与技术实现手段,可帮助 AI 从业者快速了解全生命周期下 AI 系统的风险点与对应缓解方法,为 AI 系统的安全部署和应用落地提供重要的技术参考。

图|AI 安全的威胁风险矩阵(来源:腾讯)

据了解,该矩阵由腾讯两大实验室腾讯 AI lab 和朱雀实验室联合编纂,并借鉴了网络攻防领域中成熟度高、实战意义强的开源安全研究框架 ATT&CK,全面分析了攻击者视角下的战术、技术和流程,能帮助防御者更精准地掌握安全响应方法与防御措施。相比从单一角度研究算法的安全问题,该矩阵的实用价值和参考意义更高。

该 AI 安全的威胁风险矩阵,不仅强调真实场景,还按照较成熟、研究中、潜在威胁三种成熟度直观地将攻击技术分类。据腾讯 AI Lab 介绍,矩阵编撰的核心难点在于如何选取和梳理 AI 系统安全问题的分析角度。

作为一种与其他软硬件结合运作的应用程序,AI 系统安全的分析切入角度与传统互联网产品并不完全一致。经过充分调研,该团队最终从 AI 研发部署生命周期的角度切入,总结归纳出 AI 系统在不同阶段所面临的安全风险,从全局视角来审视 AI 的自身安全。

在上述思想的指导下,该矩阵能够像字典一样便捷使用。研究人员和开发人员根据 AI 部署运营的基本情况,可对照风险矩阵,来排查潜在安全问题,并根据推荐的防御建议,降低已知的安全风险。

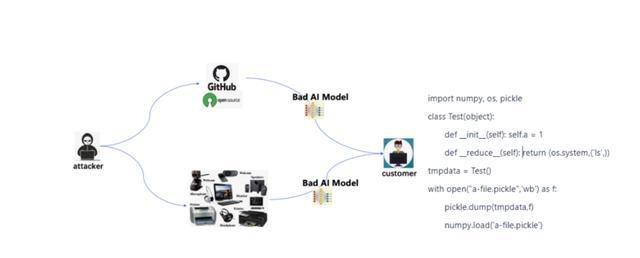

图|攻击者的入侵手段示意图(来源:腾讯)

据悉,腾讯朱雀实验室则专注于实战攻击技术研究和 AI 安全技术研究,以攻促防、守护腾讯业务及用户安全。此前,朱雀实验室就曾模拟实战中的黑客攻击路径,直接控制 AI 模型的神经元,为模型“植入后门”,在几乎无感的情况下,实现完整的攻击验证,这也是业内首个利用AI模型文件直接产生后门效果的攻击研究。