从图灵奖看人工智能的历史沉浮

导读:自1956年诞生到今天为止,尽管AI已经走完了63年的历程,但AI领域还没有诞生能比肩Microsoft这样的产业巨头。对于很多亟待解决的工业界问题,目前的AI技术水平还未达到能够实用的标准。这条道路之艰辛,可见一斑。

谨以此文,向熬过寒冬的深度学习先驱,以及依然在各个方向坚持探索的研究者致敬。能否获得图灵奖不是最重要的,信念、坚持、思考、灵感才是他们的追求。

人工智能领域的7次图灵奖

算上刚拿到的这次,AI已经七获图灵奖,是计算机科学各个领域中获图灵奖最多的方向之一,足见这一领域在整个CS中的地位。首先我们列举一下自1966年以来的历次图灵奖

1966,Alan J. Perlis,程序设计,编译器

1967,Maurice Wilkes,EDSAC,程序设计

1968,Richard Hamming,数值计算,编码,纠错码

1969,Marvin Minsky,人工智能

1970,James H. Wilkinson,数值计算

1971,John McCarthy,人工智能

1972,Edsger W. Dijkstra,程序设计

1973,Charles W. Bachman,数据库

1974,Donald E. Knuth,程序设计

1975,Allen Newell,Herbert A. Simon,人工智能

1976,Michael O. Rabin,Dana S. Scott,非确定性自动机,理论计算

1977,John Backus,程序设计

1978,Robert W. Floyd,程序设计

1979,Kenneth E. Iverson,程序设计

1980,Tony Hoare,程序设计

1981,Edgar F. Codd,数据库

1982,Stephen A. Cook。计算复杂性理论

1983,Ken Thompson,Dennis M. Ritchie,操作系统,程序设计。UNIX与c语言之父,程序员应该都知道

1984,Niklaus Wirth,程序设计

1985,Richard M. Karp,程序设计,计算复杂性理论。NP完全理论的提出者

1986,John Hopcroft,Robert Tarjan,程序设计

1987,John Cocke,编译器,计算机系统结构(RISC)

1988,Ivan Sutherland,计算机图形学

1989,William Kahan,数值计算

1990,Fernando J. Corbató,操作系统

1991,Robin Milner,程序设计

1992,Butler W. Lampson,操作系统

1993,Juris Hartmanis,Richard E. Stearns,计算复杂性理论

1994,Edward Feigenbaum,Raj Reddy,人工智能

1995,Manuel Blum,计算复杂性理论,密码学,程序验证

1996,Amir Pnueli,程序设计

1997,Douglas Engelbart,人机交互

1998,Jim Gray,数据库

1999, Frederick P. pooks, Jr.,计算机系统结构,操作系统,软件工程

2000,Andrew Chi-Chih Yao(姚期智,唯一的华人),理论计算,伪随机数,密码学,通信复杂度

2001,Ole-Johan Dahl,Kristen Nygaard,面向对象程序设计

2002,Adi Shamir,Ronald L. Rivest,Leonard M. Adleman,密码学。大名鼎鼎的RSA算法,大家都知道

2003,Alan Kay,面向对象程序设计

2004,Vinton G. Cerf,Robert E. Kahn,计算机网络,TCP/IP协议,江湖地位不用多说

2005,Peter Naur,程序设计

2006,Frances E. Allen,编译器

2007,Edmund M. Clarke,E. Allen Emerson,Joseph Sifakis,程序设计

2008,Barbara Liskov,程序设计

2009,Charles P. Thacker,设计与制造第一台PC

2010,Leslie G. Valiant,人工智能

2011,Judea Pearl,人工智能

2012,Silvio Micali,Shafi Goldwasser,密码学

2013,Leslie Lamport,分布式计算,大名鼎鼎的PAXOS算法就是他提出的,可以拜读一下

2014,Michael Stonepaker,数据库

2015,Martin E. Hellman,Whitfield Diffie,密码学

2016,Tim Berners-Lee,WWW,浏览器。互联网时代的祖师爷,江湖地位不用多说

2017,John L. Hennessy,David A. Patterson,计算机系统结构

2018,大家都知道

这里面有很多大家耳熟能详的成果和人物。学数据结构时都知道的Dijkstra;计算机课科班的同学都知道的UNIX与c语言之父(不是谭浩强),发明关系型数据库的Edgar F. Codd。其他的不一一列举了,他们是计算机科学和工业史的缩影,真的改变了我们的生活和世界。

有些领域多次获奖,如程序设计语言/算法设计/编译器累计获奖20+次之多。数据库获奖4次。人工智能在所有方向中,算是获奖非常多的了。这些多次得奖的方向,都诞生过巨头公司,如计算机系统结构的intel,amd;数据库的ORACLE;操作系统的微软,SUN,IBM等。

令人遗憾的是,自1956年诞生到今天为止,尽管AI已经走完了63年的历程,但AI领域还没有诞生能比肩Microsoft这样的产业巨头。对于很多亟待解决的工业界问题,目前的AI技术水平还未达到能够实用的标准。这条道路之艰辛,可见一斑。

接下来列举一下AI方向所获得的图灵奖

2018 Geoffrey E Hintion,Yann LeCun,Yoshua Bengio,深度学习

2011 Judea Pearl,概率图模型(贝叶斯网络)

2010 Leslie Valiant,PAC(概率近似正确)理论

1994 Edward Feigenbaum,Raj Reddy,专家系统

1975 Allen Newell,Herbert A. Simon,逻辑推理

1971 John McCarthy,LISP,逻辑推理

1969 Marvin Minsky,神经网络

自1969到1975年3次频繁获奖,下一次获奖是在时隔19年之后的1994年,它们是对AI早期成果的肯定,包括逻辑推理,知识工程,专家系统等。不幸的是这些方法并没法解决人工智能的一些核心问题,如图像识别,语音识别,这些在人类看来再简单不过的问题,却困扰了AI学者几十年。

最近3次获奖都是因为机器学习,这代表了AI方法的转变,从归纳和总结人的知识和能力然后编码实现,演变为模拟人的学习能力。这一现在看来非常简单的转变,却经历了整整数十年。机器学习从1980年兴起开始到第一次拿图灵奖,也间隔了30年。中间的几次浪潮几次寒冬,恐怕只有当年经历过那个时代的学者们才有最深刻的体会。

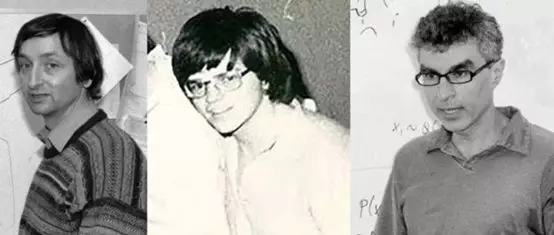

2018

这三位是深度学习的领军人物,对本轮AI兴起起到了关键作用。深度学习在计算机视觉,语音识别,自然语言处理,数据生成,决策和控制问题上取得了当前最好的效果。自2012年以来,深度学习以迅猛的速度发展,带动了此次AI的复兴,使得这一领域第一次出现了真正的大规模产业化。从计算机视觉的图像分类,目标检测,图像分割,3D,目标跟踪,到语音识别,自然语言处理中的机器翻译,以及图像、声音数据的生成,AlphaGo的成功,深度学习取得的成就让我们备受鼓舞。这一方法不是万能的,但它却在很大程度上解决了感知,数据生成,决策和控制问题,这在AI的历史上是前无古人的。

Geoffrey Hinton

Geoffrey Hinton被称为深度学习之父,他的主要贡献有

反向传播算法(BP)

1986年,Hinton与David Rumelhart等共同撰写了“Learning Internal Representations by Error Propagation”,提出了反向传播算法的完整表述。至今,这还是神经网络训练时采用的算法。

受限玻尔兹曼机(RBM)

1983年,Hinton与Terrence Sejnowski一起提出了受限玻尔兹曼机,这是一种随机、生成式神经网络,也是深度学习早期的模型之一。

逐层预训练策略训练深度神经网络

2006年,提出了用逐层预训练的策略训练多层神经网络(自动编码器),拉开了深度学习的序幕。

AlexNet

2012年,Hinton与他的学生Alex Krizhevsky和Ilya Sutskever设计了使用ReLU激活函数和Dropout机制的卷积神经网络,大幅度提升了图像分类的准确率,成为深度学习真正的开端。

Yann LeCun

Yann LeCun被称为卷积神经网络之父,其主要贡献是卷积神经网络。早在1989年,LeCun就发明了卷积神经网络,是深度卷积神经网络的雏形,这一思想被沿用至今。1998年,他又提出了LeNet网络,后来的卷积神经网络都参考了这一网络的结构。

Yoshua Bengio

个人认为,Yoshua Bengio对深度学习的贡献比不上前面了两位,公平的来说,Schmidhuber的LSTM江湖地位要超过Bengio的成果。他的主要贡献是深度学习序列建模,注意力机制,以及RNN在NLP中的应用,此外他和学生Ian Goodfellow共同提出了生成对抗网络(GAN),是目前研究最热的数据生成模型,解决了很多特定领域的数据生成问题。Bengio一直以来在致力于解决深层神经网络难以训练的问题,下面的论文是最好的证明

Y. Bengio, P. Simard, P. Frasconi. Learning long-term dependencies with gradient descent is difficult. IEEE Transactions on Neural Networks, 5(2):157-166, 1994.

Xavier Glorot, Yoshua Bengio. Understanding the difficulty of training deep feedforward neural networks. Journal of Machine Learning Research. 2010.

Xavier Glorot, Yoshua Bengio. On the difficulty of training recurrent neural networks. international conference on machine learning. 2013.

2011

继2010年获奖之后,2011年机器学习再次获奖,这次是由概率图模型的领军人物Judea Pearl获得。概率图模型是机器学习算法中的大家族,用图来对变量的概率关系进行建模,实现推理,具有较好的可解释性,也符合人的思维习惯。将概率论引入机器学习模型,这无疑是一个伟大的成就。

Judea Pearl

他的主要贡献是提出了概率图模型和因果推理算法,将概率引入机器学习,典型代表作是贝叶斯网络。HMM(隐马尔可夫模型),条件随机场(CRF)也是概率图模型家族中的成员,让很多机器学习的初学者感到困难。Judea Pearl在NIPS 2017上的演讲无人问津,不禁令世人感慨,大家都一窝蜂去做深度学习了。

2010

这是机器学习第一次拿奖,发给了机器学习基础理论的探索者Leslie G Valiant。机器学习在1980年代就诞生了一些非常重要的方法,包括决策树,神经网络,卷积神经网络等。而图灵奖对机器学习的第一肯定则选择了基础领域。包括PAC在内的一些基础结论,对设计,分析机器学习算法具有非常重要的意义。

Leslie G Valiant

Leslie G Valiant主要贡献是PAC学习(概率近似正确)理论,它从理论上回答了什么样的问题是可学习的,并给出了满足泛化性能约束的条件。可类别为金庸小说中的内功,不现于外表,但对习武之人来说却至关重要。Leslie G Valiant的成果对后面的机器学习算法设计有深远的影响,只是使用各种具体算法的同学可能对他并不熟悉。

1994

这次图灵奖颁发给了专家系统的核心人物,Edward A Feigenbaum与Raj Reddy。是人工智能时隔19年后再一次获奖,有昨日黄花的味道。

Edward A Feigenbaum

Edward Feigenbaum被称为专家系统之父。这是人工智能早期阶段的核心成果之一,因为缺乏可扩展性和通用性,以及其他局限性,现在被机器学习所取代。

Raj Reddy

Raj Reddy是识别连续性语音系统的先驱。他发明了第一代连续语音识别系统Hearsay I。在这个系统以及之后的Hearsay II, Harpy, and Dragon等系统中,他和他的学生发展了一套现代商业化语音识别技术的理论。

1975

这是AI第3次获奖。这次的奖发给了符号主义学派的创始人-Allen Newell和Herbert A.Simon。这是当年参加达特茅茨会议的人,参加这次会议,可真是拿奖的好机会,堪比参加8.1南昌起义的我军将领们最后纷纷获得元帅和大将的头衔。

Allen Newell

主要的贡献是信息处理,Information Processing Language(IPL),Logic Theory Machine,General Problem Solver,以及认知科学。

Herbert A.Simon

Simon是符号主义学派的创始人,其研究工作始终都以人的思想为中心,认为计算机是模拟人类来解决问题。研发了 “ 逻辑理论家”和“通用问题求解器”项目,在语音识别和人机交互上取得了重要进展。其目标是让计算机成为人类解决问题的高效工具。

1971

这一次的图灵奖颁发给了John McCarthy,被尊称为AI之父。

John McCarthy

John McCarthy的主要贡献是他是达特茅斯会议的发起者之一,首次提出了人工智能的概念。在α-β搜索法,机器人,计算理论,常识推理,人机交互等领域,他也做出了开创性的工作。此外,他发明了AI领域早期的一种重要工具-LISP语言。同时,对代数语言ALGOL 58和60也作出了至关重要的贡献。

1969

这是AI第一次获得图灵奖,发给了Marvin Minsky,AI的发起人之一。

Marvin Minsky

Marvin Minsky是达特茅斯会议的发起者之一。1951年他提出了关于思维如何萌发并形成的一些基本理论,并建造了一台学习机,名为Snarc。他研发了第一个神经网络模拟器、设计了最早的模拟人类机器人:Snarc,其目的是学习如何穿过迷宫,其组成中包括40个"代理"(agent ,国内资料也有把它译为"主体"、"智能体"的)和一个对成功给予奖励的系统,基于agent的计算和分布式智能是当前人工智能研究中的一个热点,明斯基也许是最早提出agent概念的学者之一。

其他未获得图论奖的重量级成果和学者

除了已经获得的7次图灵奖之外,至少在机器学习领域还有不少重量级的成果与学者至今还没有获奖,他们以及他们的成就同样值得我们尊敬与铭记。

Vladimir N. Vapnik

SVM和VC维的提出者,前者是机器学习历史上曾经出现的重量级方法,在机器学习江湖上的地位有目共睹。后者与PAC同属于机器学习的基础理论基石,是衡量分类器能力的基础指标。Vapnik与SVM在机器学习中的地位少有学者能超越,尤其是后者,从1990年代后期到深度学习出现之前,在机器学习的江湖中显赫数十载。

Yoav Freund,Robert Schapire

共同提出了AdaBoost算法,是boosting的一个可实现版本,影响力同样巨大。但他们两位之前已经获得了歌德尔奖,这是理论计算机科学的最高奖,虽不及图灵奖,但也是非常高的荣誉。AdaBoost算法当年的成功足以与SVM比肩,2001年它被用于人脸检测问题,是这一领域第一个有里程碑意义的突破。后面各种灌水的文章,都仰仗于AdaBoost的各类变种。

Leo peiman

CART(分类与回归树),随机森林,梯度提升算法的提出者,哪一个都是机器学习领域响当当的成果。CART是机器学习领域在1980年代的重要成果之一,目前还被用于一些数据分析问题。随机森林就不用多说,学过机器学习的人都知道。梯度提升算法是继AdaBoost之后第二种广为使用的boosting框架,现在炙手可热的xgboost是对它的改进。遗憾的是peiman老爷子已经去世,图灵奖之前貌似从来没颁发给不在世的人,所以是没有机会拿奖了,清明节快到了,我们祭奠他老人家一下。

Jürgen Schmidhuber

LSTM的提出者,对深度学习的发展同样做出了不可磨灭的贡献。Schmidhuber这次没拿奖是有很大的争议的,论对深度学习的贡献,笔者认为他不比Bengio小。LSTM直接促成了RNN在序列预测问题上的大规模应用,包括语音识别,自然语言处理等。他还提出了high way network,何凯明提出的目前广为应用的残差网络,被认为受到了这一结构的启发。另外,他提出的PM(Predictability Minimization)与GAN之间的原创性争议,让我们也很感慨,GAN已经有6902次的引用,而PM的引用次数却少得可怜。没有与深度学习另外3巨头一起获得这次的图灵奖,是一大遗憾。

展望未来,尽管深度学习在很多特定应用实践中取得了成功,但它仍然存在很多局限性,比如依赖大量标注的训练样本,不具备逻辑推理能力,仍然不能像人类智能那样具有适应性和通用性,对抽象数据的处理(如NLP,结构化数据)欠佳(不过现在GNN又出现了)等。如何解决余下的这些挑战,Bengio提到,“我们不应该随波逐流,现在深度学习就是这股洪流。”Geoffrey Hinton曾经说,AI不会再有寒冬,我们希望他的预言成真!老爷子的几十年如一日的坚持,值得我们所有从业者感激,敬佩与学习。